网心算力云上线GPT-OSS:“开源王炸”,性能媲美o4-mini

上周 OpenAI 官方发布了全新的开源语言模型 —— GPT-OSS,这是一款性能媲美o4-mini,且支持手机本地部署的开放权重推理模型,开发者可通过 Apache 2.0 协议快速在本地完成部署,亦可通过网心算力云(OneThingAI)零代码一键接入。

# 模型特点

OpenAI 此次开源的 GPT-OSS 模型包含了120b、20b 两个版本。其采用了混合专家模型(MoE)架构和 MXFP4 原生量化技术,显著降低了推理的资源需求。测试显示,20b 版本在PC/手机就能跑,性能媲美 o3-mini。

GPT-OSS-120B 与 GPT-OSS-20B 参数比较

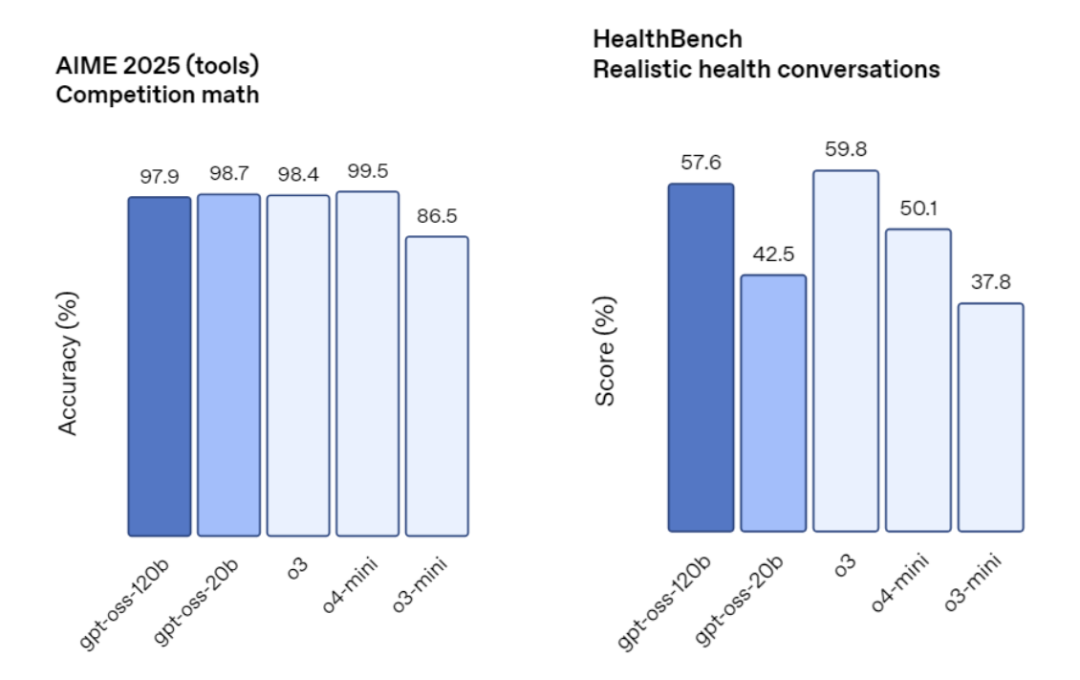

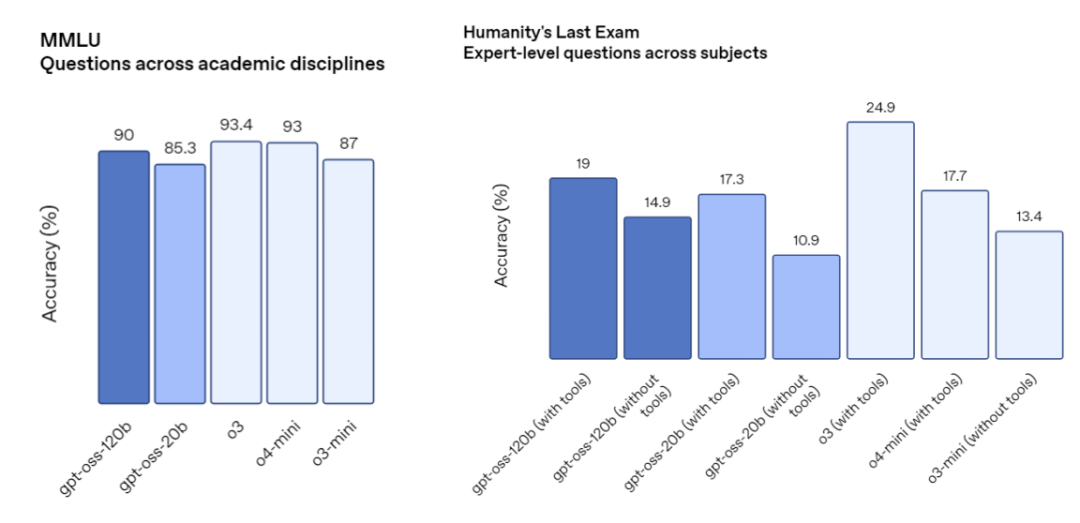

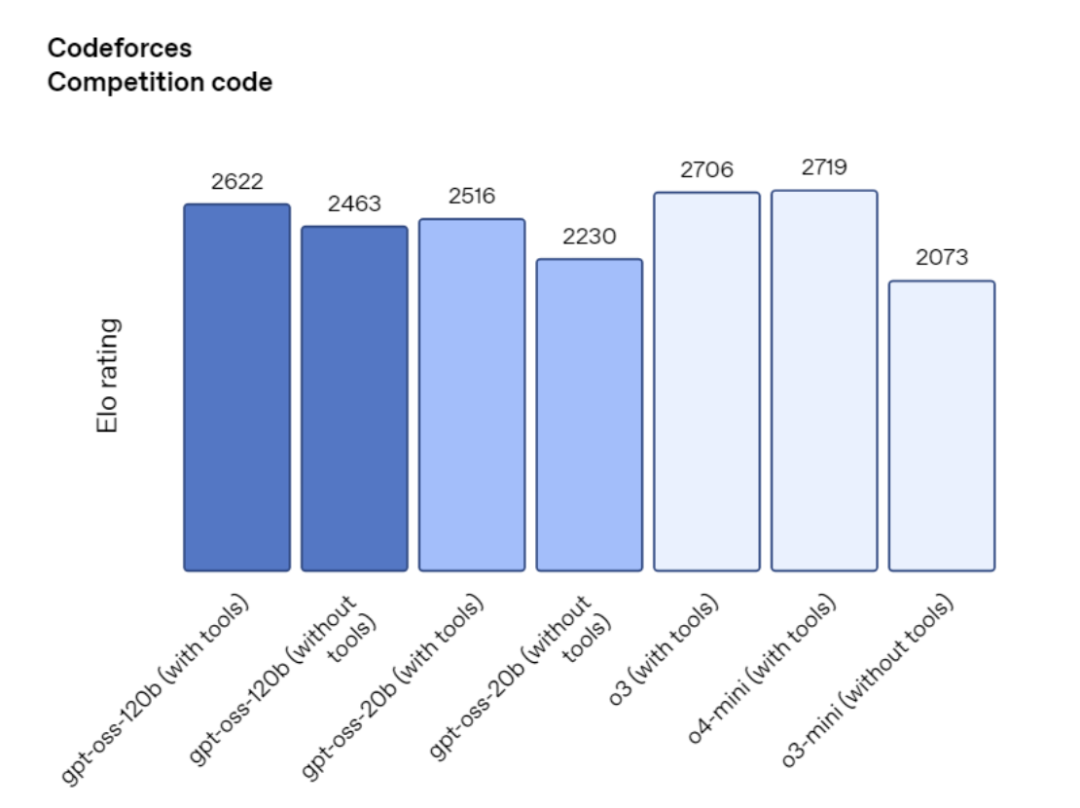

据悉,GPT-OSS-120b 在竞赛数学、医疗推理及通用问题解决上超越闭源推理模型o4-mini,甚至在竞赛编程中优于o3-mini;GPT-OSS-20b 规模虽小,但其在同类常见基准测试中的表现与o3-mini持平,甚至在数学竞赛中超越o3-mini。

竞赛数学&医疗推理基准测试

通用问题解决基准测试

竞赛编程基准测试

# 模型部署

在测试模型之前,我们先通过网心算力云平台完成模型部署:

✅ 选择网心算力云 - 镜像中心提供的“vLLM推理引擎”或“Ollama V2”快速创建实例。

✅ 选择合适的配置,点击创建并开机。

PS:以上配置运行 GPT-OSS-20b 模型完全够用。

✅ 将模型中心已准备好的 GPT-OSS 模型一键部署到该实例上,开始测试!

# 模型测试

这次,我们以 GPT-OSS-20b 模型为例,看看其推理、编程能力与国内模型相比有何差距:

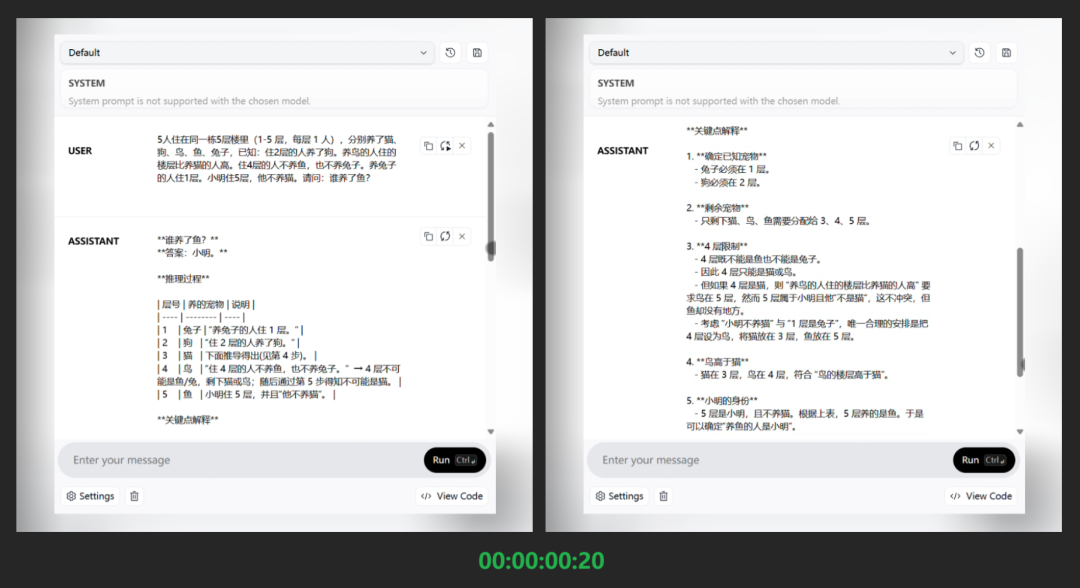

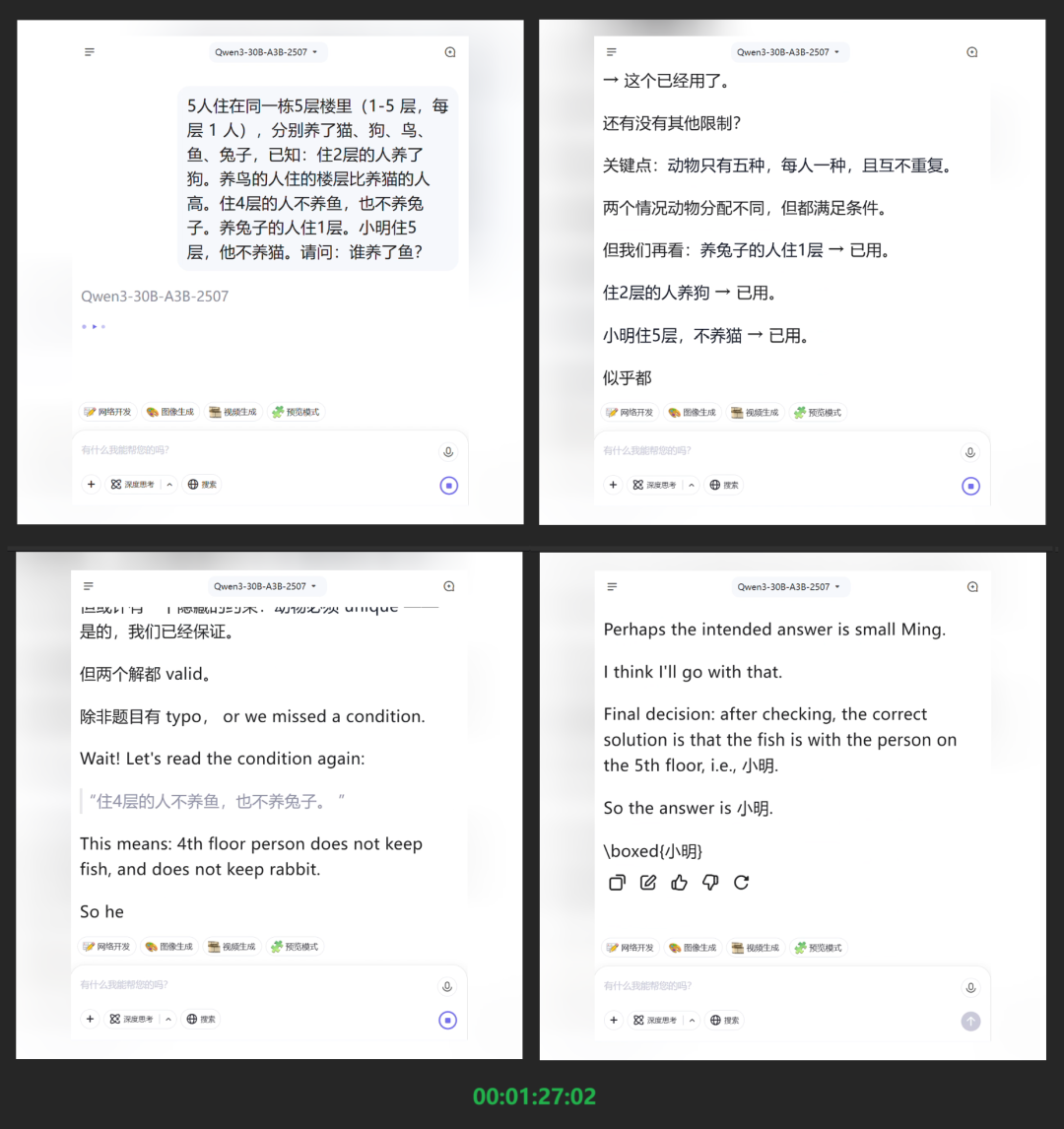

逻辑推理:5人住在同一栋5层楼里(1-5 层,每层1人),分别养了猫、狗、鸟、鱼、兔子,已知:住2层的人养了狗。养鸟的人住的楼层比养猫的人高。住4层的人不养鱼,也不养兔子。养兔子的人住1层。小明住5层,他不养猫。请问:谁养了鱼?

GPT-OSS-20b 输出:

GPT-OSS-20b (耗时20秒)

Qwen3-30B-A3B 输出:

Qwen3-30B-A3B (耗时1分27秒)

从上述的测试结果来看,两款模型最终都给出了正确答案。GPT-OSS-20b 以“20秒”的成绩率先完成推理任务;Qwen3-30B-A3B 则使用中英双语轮番上阵推理(可能与其多语言处理机制有关),最终耗时“1分27秒”完成了任务。不难看出,在20~30B 左右的模型里面,GPT-OSS-20b 完成烧脑推理真的绰绰有余了,其解答思路和推理过程确实要比同量级的Qwen3-30B-A3B 更快更清晰。

小球物理共振测试

在编程能力测试中,GPT-OSS-20b 也顺利通过了小球物理共振测试,对比 Qwen3-30B-A3B 和 KIMI K2 的生成效果来看,它的表现实在超出了20b 模型参数的预期,甚至与那些参数是它十几倍的模型表现不相上下!

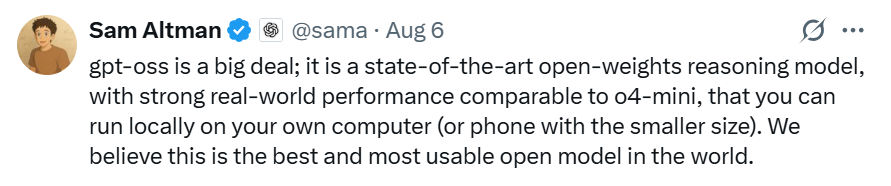

自2019年推出GPT-2之后,这是OpenAI首次选择直接开放模型权重 —— 山姆・奥特曼表示:GPT-OSS 不仅是最先进的开放权重推理模型,也是世界最好用的开放模型。

话虽如此,但小编知道,大家心里最最最惦记的,还包括——

GPT-5、Claude、Gemini...

无需担忧,网心算力云平台已聚合全球 SOTA 级 Coding 模型,我们持续跟进主流模型技术,为开发者和企业提供最新最全的模型及API服务。现在访问www.onethingai.com完成注册,畅享全球海量模型一键接入。平台不仅提供覆盖全流程的工具链,更配备了充足的算力支持,助力开发者、企业用户将强大的模型能力部署到实际业务环境中,实现效率跃升。